מחקר בינה מלאכותית מתקדם כיום בקצב מרשים. יותר ויותר שחקנים בתעשייה מצפים כעת לראות את הראשוןבינה מלאכותית כללית (IAG), עם יכולות הנמקה גבוהות יותר מאלו של בני אדם, בעוד כמה שנים. נקודת מבט מרגשת כמו הנוגעת, ולא בכדי: מומחים שקלו זה מכבר שמערכת כזו יכולהלזרוע מחלוקת חסרת תקדים בתרבות שלנו.

זהו נושא שלעתים קרובות נחקר על ידי סופרים בדיוניים ביצירות כמו2001: אודיסיאה של החלל-שליחות קטלנית, אומַטרִיצָהאם נזכיר כמה. אך ככל שהם מתקשים, תרחישים אלה הם כמובן די קריקטוריים.

אם בינה מלאכותית מתקדמת מאוד יום אחד מתחילה לגרום נזק לאנושות, היא יכולה גם לעשות זאת בצורה עדינה ופחות קיצונית. כדי להימנע מאסון אפשרי, כעת יש לקבוע קבוצה של הנחיות מוצקות. וזה בדיוק מושא האחרוןטכניקת נייר De Deepmind, הבחין על ידיARS Technicaו

למי שאינו מוכר, סניף גוגל זה הוא אחת החברות המתקדמות ביותר בענף. תורת המשחקים (אלפזרו-אלפגו...) לביולוגיה מבנית (אלפפולד) עוברים בתחזיות מזג אוויר (Gencast) אומיזוג גרעיני, היא פיתחה מערכות רבות מבוססות AI כדי להתמודד עם בעיות שפעם נראו בלתי משתלמות לחלוטין.

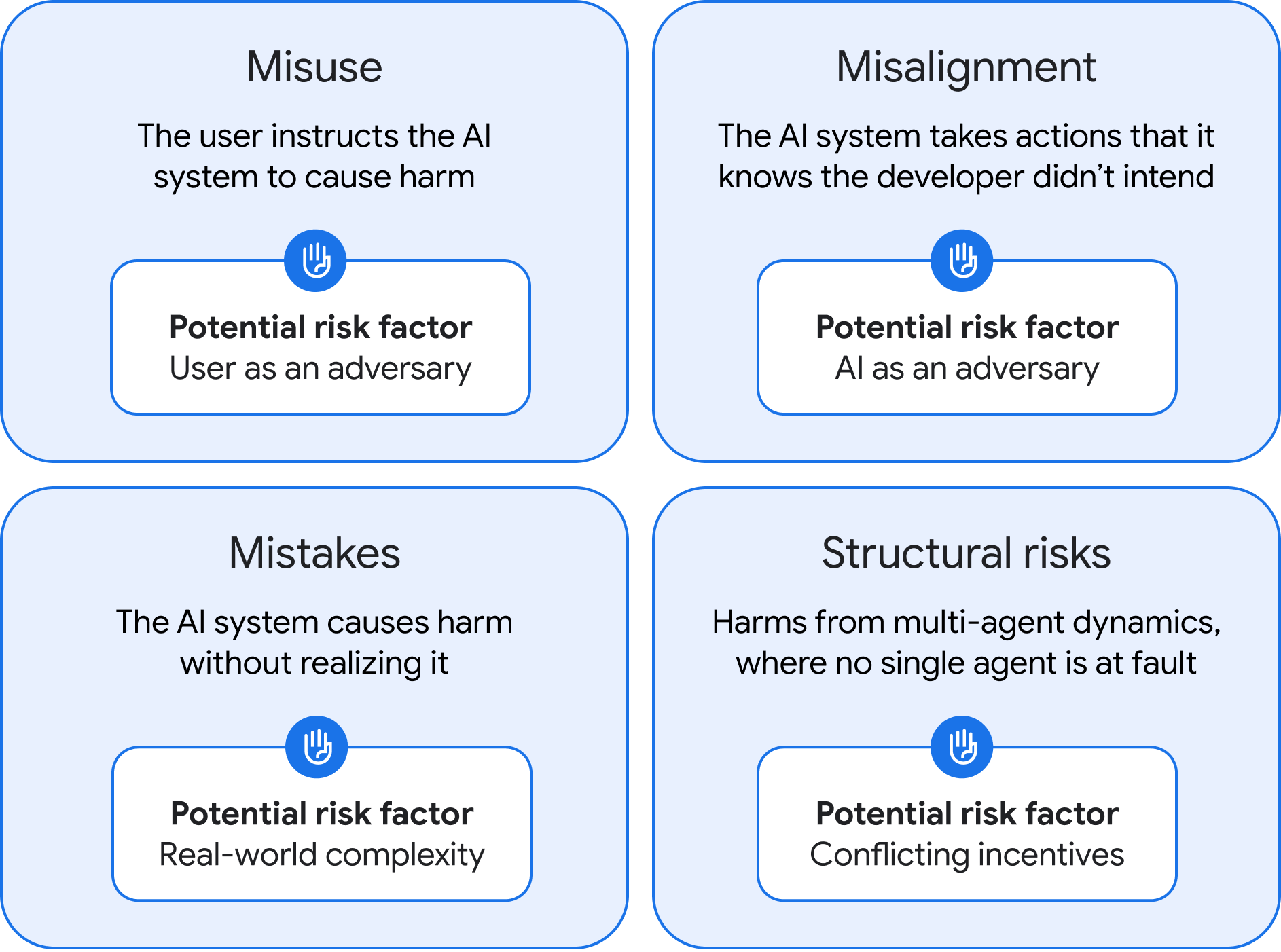

לאחרונה פרסמו חוקריו אנייר ארוךהבוחן גישות שונות כדי להגביל את הסיכונים הקשורים להתפתחות IAG. זה מתמקד בפרט בסוגים השונים של סיכונים הקשורים למערכת כזו. בסך הכל, המחברים זיהו ארבע קטגוריות עיקריות.

נשק לבני אדם לא מכוונים

הראשון נוגע למה ש- DeepMind מתאר כ"הן ""הִתעַלְלוּת ». במקרה זה, לא המערכת עצמה היא בעייתית ישירות, אלא בני אדם שמסייטים אותה. נראה ברור כי ככלי חזק כמו IAG עלול לגרום נזק גדול אם הוא נפל לידיהם של שחקנים חולים מכוונים. זה האחרון יכול, למשל, לבקש ממנו לנצל פגיעויות ביטחון ברשת קריטיות, במיוחד ברמה של תשתיות קריטיות כמו תחנות כוח גרעיניות, ליצירת כלי נשק חיידקים אימתניים וכן הלאה.

לפיכך, DeepMind מאמינה כי על חברות להקים באופן אידיאלי פרוטוקולי אימות ואבטחה מוצקים במיוחד. הכותבים מתעקשים גם על החשיבות של פיתוח טכניקות המאפשרות להיאלץ לדגמי IA "לִשְׁכּוֹחַ»נתונים, על מנת שיוכלו לחתוך את הדשא מתחת לכף הרגל במצב חירום אם תרחיש אסון מתחיל להפנות את קצה אפו.

שגיאות יישור

הקטגוריה השנייה מפגישה את כל הבעיות הקשורות למה שמכונה Theמַעֲרָך- הבטחת המודלים הללו "יבינו" את הערכים והציפיות של בני האדם, ויעניקו להם עדיפות בעת משחקים. לעומת זאת, מערכת חולה -יישור יכולה לבצע פעולות בהן הוא יודע שהם אינם תואמים את חזונו של יוצרם.

זה המקרה שלרוב חוזר בבדיון. לדוגמה, אם HAL 9000 מנסה לחסל את הצוות מהכלי ב2001: אודיסיאה של החללזה בגלל שהוא מחשיב שלצלחת המשימה יש ערך יותר מחיי אדם. אותה תצפית לסקינט בסאגהשליחות קטלנית: בזמן שהוא נועד בתחילה להגן על האנושות, הוא סוף סוף הגיע למסקנה שזה היה איום שראוי להיפטר בכל מחיר.

כדי להימנע מתרחיש מסוג זה, DeepMind מציע פיתרון ראשון מעניין:לגרום ל- IAGS לעבוד בזוגותו במקום להתפתח לבד, הם יפוקחו כל העת על ידי שיבוט זהה לחלוטין, ובכך יפחיתו את הסיכונים של הסחף. אולם מחברי העיתון מכירים בכך שגישה זו ללא ספק תהיה רחוקה מלהיות בלתי ניתנת לניתוק.

במקביל, לפיכך הם ממליצים להריץ את ה- IAG העתידי ב- "ארגזי חול וירטואלייםמונח זה מייעד חללים דיגיטליים המבודדים משאר המערכת, המשמשים כיום בעיקר בתחום אבטחת הרשת כדי לבחון תוכניות רגישות מבלי להסתכן בהשתאר שאר התשתיות. בתיאוריה, אם מתעוררת בעיה, די בכך כדי להשבית זאתארגז חוללשלול מ- IAG את יכולתו לפגוע. עם זאת, ניתן לתהות אם מערכת ערמומית כזו לא הייתה יכולה למצוא דרך לברוח ממנה ...

כאשר AI מאבד את הדוושות

הקטגוריה השלישית, שכותרתה "שגיאות", אולי נראה די דומה לבעיות יישור. אך עם זאת הוא מבוסס על הבחנה מכריעה: כאן, מודל ה- IA אינו מודע לתוצאות המזיקות של מעשיו. הוא חושב שהוא לגמרי ליד הצלחת, כמו כאשר הפונקציונליותסקירה כללית של AIמגוגל המליצה על משתמשי האינטרנטשים דבק על הפיצות שלהםכדי למנוע גבינה מומסת להחליק.

דוגמה זו מוכנה לחייך, אך תוכלו לדמיין בקלות מצבים שבהם שגיאות כאלה (המכונות לפעמים הזיות) יכולות להיות בעלות השלכות איומות. תאר לעצמך, למשל, כי ייעוד צבאי הוא לאתר את סימני האזהרה של שביתה גרעינית; לאחר מכן זה יכול לעורר "תגולות תגמול" בלתי מוצדקות לחלוטין, מה שמוביל להשמדה מוחלטת של חלק מהעולם על בסיס שגיאה פשוטה.

החדשות הרעות הן שאין ממש גישה כללית להגבלת השגיאות הללו. עבור מחברי נייר, אפוא יהיה חיונילפרוס IAG בעתיד בהדרגה, עםבדיקות קפדניות בכל שלבומעל הכללהגביל את יכולתם לפעול באופן עצמאיו

סיכונים מבניים גדולים -בקנה מידה

הקטגוריה האחרונה, ואולי המעניינת ביותר, מאגדת את מה שמכנה DeepMind "סיכונים מבניים". כאן הבעיה לא תצא ממערכת מבודדת אחת, אלא אינטראקציות בין מספר מערכות מורכבות המשולבות ברמות שונות של החברה שלנו.

יחד, מערכות אינטראקטיביות אלה יכולות "צובר שליטה חשובה יותר ויותר על המערכות הכלכליות והפוליטיות שלנו", במחזור המידע וכן הלאה. במילים אחרות, IAG בסופו של דבר ישתלט על החברה שלנו, בעוד שבני אדם היו רק משכנים אורגניים לא משמעותיים על לוח שחמט וירטואלי עצום.תרחיש דיסטופי שהוא בהחלט קר מאחור.

החוקרים מציינים כי קטגוריית סיכונים זו ללא ספק תהיה הקשה ביותר לסתור, מכיוון שההשלכות הפוטנציאליות תלויות ישירות באופן בו אנשים, תשתיות ומוסדות עובדים ומתקיימים אינטראקציה.

נכון לעכשיו, אף אחד לא יודע בדיוק מתי - או אפילו אם - IAG אמיתי באמת יופיע. אך בהקשר הנוכחי, זה יהיה חוסר חוסר חוסר יכולת לא להתייחס ברצינות לאפשרות זו. לפיכך יהיה מעניין לראות אם Openai ואחרים יבססו את עבודתם העתידית על מאמר זה בהחלט מופשט, אך בכל זאת מעניין מאוד.

🟣 לא להחמיץ שום חדשות בעיתון החנון, הירשםחדשות גוגלואילךWhatsApp שלנוו ואם אתה אוהב אותנו, יש לנועלון כל בוקרו